На этом шаге мы рассмотрим вопросы, связанные с валидностью полученных результатов.

Получив такой результат, мы могли бы поддаться искушению и заявить, что нашли модель, которая дает 97%-ную правильность на нашем наборе данных. Однако это заявление может быть чрезмерно оптимистичным (или просто неверным) по следующей причине: мы перебрали множество значений параметров и выбрали ту комбинацию значений, которая дает наилучшую правильность на тестовом наборе, но это вовсе не означает, что на новых данных мы получим такое же значение правильности. Поскольку мы использовали тестовый набор для настройки параметров, мы больше не можем использовать его для оценки качества модели. Это та же самая причина, по которой нам изначально нужно разбивать данные на обучающий и тестовый наборы. Теперь для оценки качества модели нам необходим независимый набор данных, то есть набор, который не использовался для построения модели и настройки ее параметров.

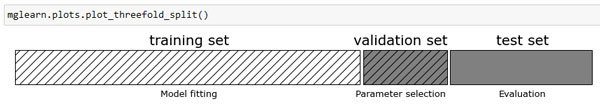

Один из способов решения этой проблемы заключается в том, чтобы разбить данные еще раз, таким образом, мы получаем три набора: обучающий набор для построения модели, проверочный (валидационный) набор для выбора параметров модели, а также тестовый набор для оценки качества работы выбранных параметров. Рисунок 1 показывает, как это выглядит:

[In 18]:

mglearn.plots.plot_threefold_split()

Рис.1. Тройное разбиение данных на обучающий набор, проверочный набор и тестовый набор

После выбора наилучших параметров с помощью проверочного набора проверки, мы можем заново построить модель, используя найденные настройки, но теперь на основе объединенных обучающих и проверочных данных. Таким образом, мы можем использовать для построения модели максимально возможное количество данных. Это приводит к следующему программному коду:

[In 19]: from sklearn.svm import SVC # разбиваем данные на обучающий+проверочный набор и тестовый набор X_trainval, X_test, y_trainval, y_test = train_test_split( iris.data, iris.target, random_state=0) # разбиваем обучающий+проверочный набор на обучающий и проверочный наборы X_train, X_valid, y_train, y_valid = train_test_split( X_trainval, y_trainval, random_state=1) print("Размер обучающего набора: {} " "размер проверочного набора: {} " "размер тестового набора: {}\n". format(X_train.shape[0], X_valid.shape[0], X_test.shape[0])) best_score = 0 for gamma in [0.001, 0.001, 0.1, 1, 10, 100]: for C in [0.001, 0.001, 0.1, 1, 10, 100]: # для каждой комбинации параметров обучаем SVC svm = SVC(gamma=gamma, C=C) svm.fit(X_train, y_train) # оцениваем качество SVC на тестовом наборе score = svm.score(X_valid, y_valid) # если получаем наилучшее значение правильности, сохраняем значение и параметры if score > best_score: best_score = score best_parameters = {'C': C, 'gamma': gamma} # заново строим модель на наборе, полученном в результате объединения обучающих # и проверочных данных, оцениваем качество модели на тестовом наборе svm = SVC(**best_parameters) svm.fit(X_trainval, y_trainval) test_score = svm.score(X_test, y_test) print("Лучшее значение правильности на проверочном наборе: {:.2f}".format(best_score)) print("Наилучшие значения параметров: ", best_parameters) print("Правильность на тестовом наборе с наилучшими параметрами: {:.2f}".format(test_score)) Размер обучающего набора: 84 размер проверочного набора: 28 размер тестового набора: 38 Лучшее значение правильности на проверочном наборе: 0.96 Наилучшие значения параметров: {'C': 10, 'gamma': 0.001} Правильность на тестовом наборе с наилучшими параметрами: 0.92

Лучшее значение правильности на проверочном наборе составляет 96%, что немного ниже значения правильности, полученного для тестового набора ранее, вероятно, из-за того, что мы использовали меньше данных для обучения модели (размер X_train теперь стал меньше, поскольку что мы разбили наш набор данных дважды). Однако значение правильности на тестовом наборе, значение, которое показывает реальную обобщающую способность - стало еще ниже, 92%. Таким образом, мы можем утверждать, что правильность классификации новых данных составляет 92%, а не 97%, как мы думали ранее!

Наличие различий между обучающим, проверочным и тестовым наборами имеет принципиально важное значение для применения методов машинного обучения на практике. Любой выбор, сделанный, исходя из правильности на тестовом наборе, "сливает" модели информацию тестового набора. Поэтому важно иметь отдельный тестовый набор, который используется лишь для итоговой оценки. Осуществление всего разведочного анализа и отбора модели с помощью комбинации обучающего и проверочного наборов и резервирование тестового набора для итоговой оценки является хорошей практикой. Данная практика является верной даже при проведении разведочной визуализации. Строго говоря, оценка качества моделей и выбор наилучшей из них с помощью тестового набора, использующегося для отбора параметров, приведет к чрезмерно оптимистичной оценке правильности модели.

На следующем шаге мы рассмотрим решетчатый поиск с перекрестной проверкой.