На этом шаге мы поясним эти термины.

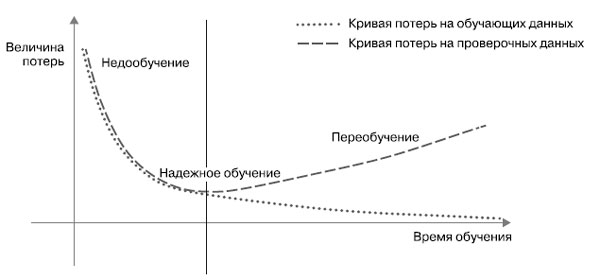

Во всех трех примерах, приведенных на предыдущих шагах, качество модели на проверочных данных всегда достигало максимума после небольшого количества эпох и затем начинало снижаться. Это закономерность (рисунок 1). Далее вы увидите, что она проявляется в моделях любых типов и с любым набором данных.

Рис.1. Каноническое поведение модели при переобучении

В начале обучения оптимизация и общность коррелируют: чем ниже потери на обучающих данных, тем они ниже и на контрольных данных. Пока так происходит, принято говорить, что модель недообучена: прогресс еще возможен; сеть еще не смоделировала все релевантные шаблоны в обучающих данных. Однако после нескольких итераций на обучающих данных общность перестает улучшаться, метрики оценки на проверочных данных останавливают свой рост и затем начинают ухудшаться: наступает эффект переобучения модели. Другими словами, модель начинает запоминать шаблоны, характерные для обучающих данных, но нетипичные для новых.

Переобучение особенно вероятно, когда исходные данные зашумлены, если в них присутствует элемент неопределенности или они содержат редкие признаки. Давайте рассмотрим конкретные примеры.

На следующем шаге мы рассмотрим зашумленные данные.